La baisse progressive du trafic sur un site Internet constitue l'un des signaux les plus préoccupants pour une entreprise qui a investi dans sa présence en ligne. Contrairement à une rupture brutale, facilement identifiable, cette érosion mensuelle passe souvent inaperçue jusqu'au moment où l'écart devient significatif. Les tableaux de bord Analytics affichent des courbes descendantes, les leads se raréfient, et les équipes commerciales constatent une baisse des opportunités générées par le canal digital.

Cette situation n'est jamais le fruit du hasard. Elle résulte d'une combinaison de facteurs techniques, éditoriaux et concurrentiels qui s'accumulent et finissent par impacter durablement la visibilité organique. Comprendre les mécanismes à l'œuvre permet d'identifier les leviers correctifs avant que la perte ne devienne structurelle et difficilement réversible.

L'Agence Easy, basée à Saint-Rémy-de-Provence, observe depuis plus de 20 ans ces schémas de dégradation progressive. Les diagnostics réalisés sur plusieurs centaines de sites révèlent des constantes : la perte de trafic n'est jamais monofactorielle, elle s'installe lentement, et plus l'intervention est tardive, plus les efforts de redressement sont conséquents.

Perte de trafic : phénomène normal ou alerte ?

Toute baisse de fréquentation ne justifie pas nécessairement une intervention immédiate. Les données de trafic connaissent naturellement des fluctuations liées à des cycles prévisibles ou à des événements ponctuels. La difficulté réside dans la capacité à distinguer une variation normale d'un signal d'alerte nécessitant une action corrective.

Variations saisonnières

De nombreux secteurs d'activité connaissent des cycles de demande marqués. Un site spécialisé dans les équipements de chauffage verra logiquement son trafic augmenter en automne et diminuer au printemps. Un site dédié aux fournitures scolaires enregistrera un pic en août-septembre puis une baisse naturelle le reste de l'année.

Ces variations saisonnières sont prévisibles et doivent être intégrées dans l'analyse des tendances. Comparer le trafic du mois de janvier 2026 avec celui de décembre 2025 peut conduire à des conclusions erronées si l'activité est par nature cyclique. L'analyse pertinente consiste à comparer des périodes homogènes : janvier 2026 versus janvier 2025, ou à travailler sur des moyennes mobiles qui lissent les effets de saisonnalité.

Rupture brutale : signal fort

Une chute soudaine du trafic, de l'ordre de 30 % à 50 % en quelques jours, constitue toujours un signal critique. Les causes peuvent être diverses : pénalité algorithmique suite à une mise à jour Google, problème technique majeur (désindexation, erreurs serveur, blocage du crawl), attaque malveillante, ou encore erreur de manipulation lors d'une intervention technique.

Ces ruptures brutales sont relativement faciles à diagnostiquer car elles coïncident généralement avec un événement identifiable dans l'historique du site ou avec le calendrier des mises à jour des moteurs de recherche. La réactivité est déterminante : plus l'intervention est rapide, plus les chances de récupération complète sont élevées.

Indicateurs à surveiller

Au-delà du volume de trafic global, plusieurs indicateurs permettent d'affiner le diagnostic. Le trafic organique (provenant des moteurs de recherche) est le plus révélateur des problématiques SEO. Une baisse du trafic organique alors que le trafic direct ou référent reste stable pointe vers des problématiques de positionnement ou de visibilité dans les résultats de recherche.

Le nombre de pages vues par session, le taux de rebond, et la durée moyenne des sessions constituent également des signaux précieux. Une baisse du trafic accompagnée d'une dégradation de ces métriques d'engagement suggère que les visiteurs qui parviennent encore sur le site sont moins satisfaits de ce qu'ils y trouvent.

L'analyse par segment géographique, par device (mobile/desktop), ou par page d'atterrissage permet d'identifier si la baisse est généralisée ou concentrée sur certains segments spécifiques, orientant ainsi les actions correctives vers les zones les plus impactées.

Causes SEO fréquentes

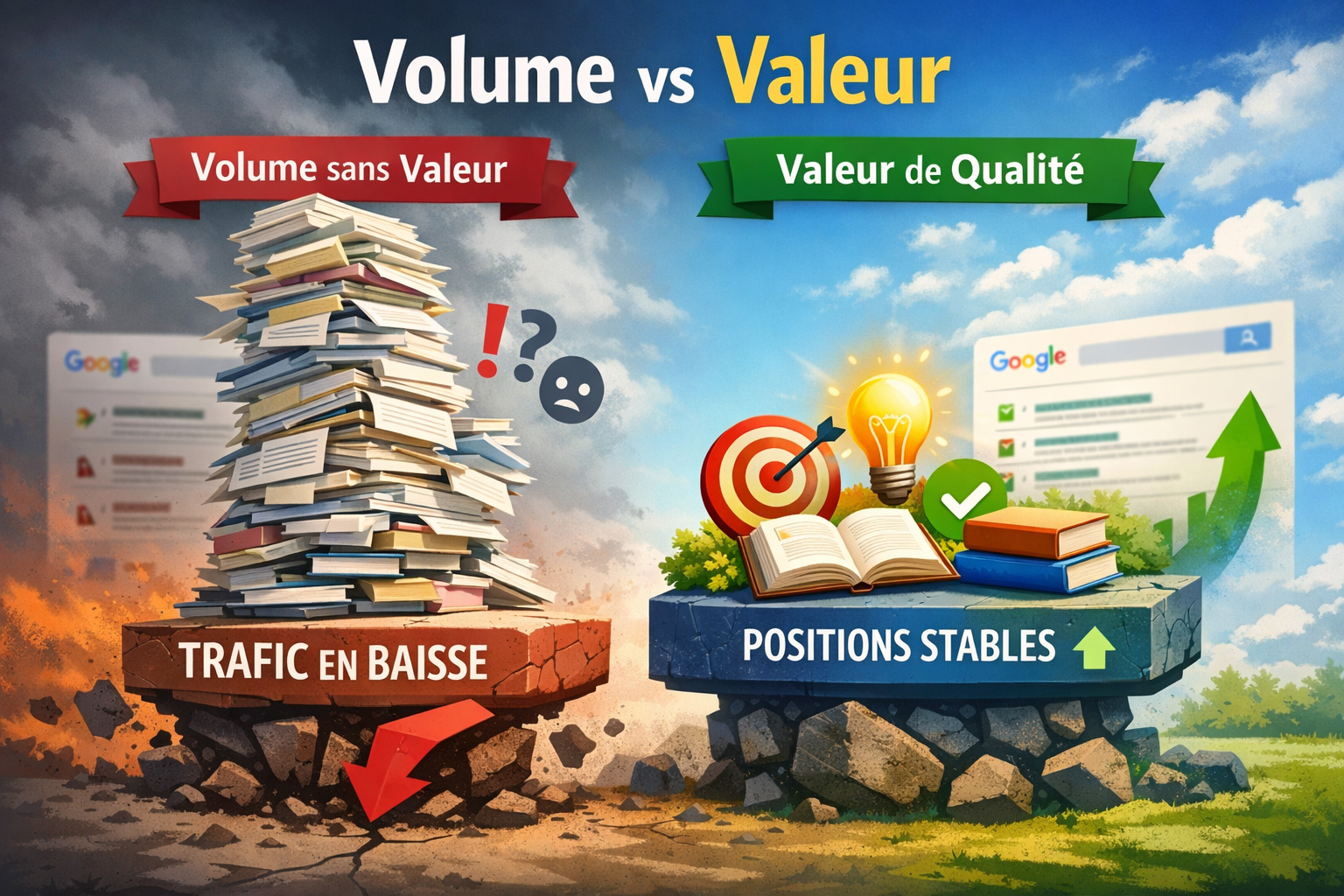

Les facteurs liés au référencement naturel constituent la première source de perte de trafic organique. L'écosystème SEO évolue en permanence : algorithmes des moteurs, comportements des utilisateurs, pratiques des concurrents. Un site qui stagne techniquement et éditorialement perd mécaniquement du terrain.

Concurrence qui progresse

Le référencement naturel est par essence un jeu à somme nulle sur les premières positions. Lorsqu'un concurrent investit dans son SEO, produit des contenus de meilleure qualité, optimise son architecture technique, ou obtient de nouveaux backlinks de qualité, il gagne des positions au détriment des autres acteurs présents sur les mêmes requêtes.

Cette dynamique concurrentielle est particulièrement visible sur les secteurs à forte valeur ajoutée où les enjeux de visibilité justifient des investissements SEO importants. Un site qui maintient ses positions pendant plusieurs années sans évolution significative finit inévitablement par être dépassé par des acteurs plus dynamiques.

L'observation terrain montre que la stratégie de contenus SEO demeure l'un des leviers les plus déterminants pour maintenir ou renforcer ses positions face à une concurrence active.

Contenus qui vieillissent

Google privilégie la fraîcheur et la pertinence des contenus. Un article publié il y a trois ans, aussi qualitatif soit-il, perd progressivement de sa valeur s'il n'est pas mis à jour. Les informations deviennent obsolètes, les statistiques datent, les liens externes se brisent, et les algorithmes détectent ce vieillissement.

Ce phénomène est particulièrement marqué sur les contenus informationnels liés à des sujets évolutifs : technologies, réglementation, pratiques professionnelles, données de marché. Un contenu qui était en première position il y a deux ans peut glisser progressivement en deuxième page sans intervention de mise à jour ou d'enrichissement.

La stratégie de maintenance éditoriale, souvent négligée, s'avère pourtant déterminante. Actualiser régulièrement les contenus les plus performants permet de maintenir leurs positions et d'éviter la dégradation progressive du trafic qu'ils génèrent. Cette approche se révèle généralement plus efficace que la production systématique de nouveaux contenus sans attention portée à l'existant.

Requêtes perdues

L'analyse des requêtes qui génèrent du trafic via la Google Search Console révèle fréquemment des pertes de positionnement sur des expressions clés. Un site qui se positionnait en 3ᵉ position sur une requête stratégique et qui glisse en 8ᵉ position voit son trafic sur cette requête diminuer de 70 % à 80 %, simplement en raison de la mécanique des taux de clics selon les positions.

Ces pertes de requêtes peuvent résulter de plusieurs facteurs : contenus concurrents de meilleure qualité, changements dans l'intention de recherche détectée par Google, modifications algorithmiques défavorables, ou encore cannibalisation interne entre plusieurs pages du site ciblant des requêtes trop proches.

Le diagnostic précis de ces pertes de requêtes, page par page et mot-clé par mot-clé, constitue le point de départ de toute stratégie de reconquête. Il permet d'identifier les pages prioritaires à optimiser et les contenus à renforcer pour récupérer le terrain perdu.

Causes techniques possibles

Les problématiques techniques constituent la deuxième grande famille de causes de perte de trafic. Contrairement aux facteurs SEO éditoriaux, les problèmes techniques peuvent avoir des impacts très rapides et massifs, mais ils sont aussi généralement plus simples à résoudre une fois correctement identifiés.

Lenteur / instabilité

La vitesse de chargement des pages figure parmi les critères de classement officiels de Google depuis plusieurs années, et son importance n'a cessé de croître avec la généralisation du mobile. Un site qui se dégrade techniquement, dont les temps de réponse s'allongent progressivement, voit ses positions se dégrader mécaniquement.

Cette dégradation peut résulter de multiples causes : accumulation de plugins mal optimisés, base de données qui grossit sans maintenance, images non compressées, scripts tiers mal intégrés, hébergement insuffisant face à la croissance du trafic, ou encore attaques DDoS qui dégradent les performances serveur.

L'instabilité du site (pages indisponibles de manière aléatoire, erreurs 500 récurrentes, temps de réponse très variables) constitue un signal encore plus critique. Google pénalise lourdement les sites qui ne garantissent pas une disponibilité constante, car cela dégrade l'expérience des utilisateurs arrivant depuis les résultats de recherche.

Les Core Web Vitals, indicateurs de performance centrés sur l'expérience utilisateur réelle, sont désormais intégrés dans les critères de classement. Un site qui affiche des métriques dégradées sur ces indicateurs (LCP, FID, CLS) perd progressivement des positions, même si son contenu reste pertinent.

Problèmes d'indexation

Les difficultés d'indexation représentent une cause fréquente mais souvent méconnue de perte de trafic. Un site peut techniquement fonctionner parfaitement du point de vue de l'utilisateur tout en devenant progressivement invisible pour les robots de Google en raison de blocages techniques.

Ces blocages peuvent prendre diverses formes : fichier robots.txt mal configuré qui bloque des sections entières du site, balises meta robots en noindex introduites par erreur, problèmes de crawl budget sur les sites à forte volumétrie, architecture en JavaScript mal gérée qui empêche l'indexation du contenu, redirections en chaîne qui découragent le crawl, ou encore canonicales mal configurées qui indiquent aux moteurs des URL incorrectes.

La Search Console fournit des indicateurs précieux sur l'état de l'indexation : nombre de pages indexées, pages exclues, erreurs de couverture, problèmes de sitemap. Une baisse du nombre de pages indexées constitue toujours un signal d'alerte nécessitant une investigation immédiate. Dans certains cas observés par l'Agence Easy, des sites avaient perdu 40 % à 60 % de leurs pages indexées sans que les équipes internes ne s'en aperçoivent, expliquant une baisse proportionnelle du trafic organique.

Changements (refonte, plugins, code)

Les interventions techniques sur un site en production comportent toujours un risque SEO si elles ne sont pas anticipées et sécurisées. Une refonte mal gérée constitue la cause la plus fréquente de perte brutale et massive de trafic : changements d'URL non accompagnés de redirections 301, contenus supprimés ou restructurés sans préservation du maillage interne, balisage HTML modifié de manière défavorable.

Même des interventions apparemment mineures peuvent avoir des impacts significatifs. L'installation d'un plugin de cache mal configuré peut générer des versions de pages non indexables. Une mise à jour de CMS peut introduire des modifications dans la structure HTML qui dégradent la compréhension du contenu par les moteurs. Un changement de thème WordPress peut modifier l'architecture de données structurées et faire disparaître des rich snippets qui généraient un taux de clic supérieur.

La méthodologie éprouvée consiste à systématiquement réaliser un audit avant/après sur tout projet de refonte ou de migration technique, à mettre en place un plan de redirections exhaustif, et à monitorer quotidiennement les indicateurs critiques pendant les semaines suivant la mise en ligne. De nombreux cas montrent que certains problèmes introduits lors d'une refonte ne deviennent visibles dans les statistiques que 2 à 3 mois après la mise en production, lorsque Google a eu le temps de recrawler l'ensemble du site.

Causes liées à l'expérience utilisateur

Au-delà des aspects purement techniques ou SEO, l'expérience vécue par les visiteurs sur le site conditionne directement les performances de trafic à moyen terme. Google intègre de plus en plus de signaux comportementaux dans ses algorithmes de classement : taux de rebond, temps passé, taux de clics depuis les résultats de recherche.

Hausse du taux de rebond

Un taux de rebond élevé ou en augmentation signale que les visiteurs quittent le site rapidement après y être arrivés, sans consulter d'autres pages. Ce signal indique généralement un décalage entre la promesse faite dans les résultats de recherche et la réalité trouvée sur la page : contenu peu pertinent, navigation confuse, design rebutant, publicités envahissantes, ou temps de chargement excessif.

Google interprète ces signaux comportementaux comme un indicateur de qualité. Un site dont les visiteurs repartent systématiquement après quelques secondes sera progressivement déclassé au profit de sites concurrent où les utilisateurs restent plus longtemps et consultent plusieurs pages.

L'analyse des pages présentant les taux de rebond les plus élevés permet d'identifier les contenus à retravailler en priorité. Souvent, il ne s'agit pas de problèmes de qualité éditoriale pure, mais plutôt d'inadéquation entre l'intention de recherche et la structure de la réponse apportée, ou de problèmes d'ergonomie qui découragent la poursuite de la navigation.

Navigation difficile

Une architecture de navigation mal conçue constitue un frein majeur à la fois pour les utilisateurs et pour les robots d'indexation. Lorsque les visiteurs peinent à trouver l'information recherchée, qu'ils doivent effectuer trop de clics pour accéder aux contenus essentiels, ou que la logique d'organisation n'est pas intuitive, le site ne remplit plus sa fonction première.

Cette difficulté se manifeste par plusieurs indicateurs : nombre de pages par session en baisse, utilisation intensive de la fonction recherche interne, parcours de navigation erratiques, abandons sur des pages intermédiaires qui devraient conduire à des conversions.

Les diagnostics terrain révèlent fréquemment des sites dont la navigation s'est complexifiée au fil du temps, par ajouts successifs de rubriques, de sous-rubriques, de contenus transverses, sans jamais prendre le temps de repenser l'architecture globale. Cette sédimentation progressive rend le site de moins en moins lisible et de moins en moins performant, tant pour les utilisateurs que pour le référencement naturel.

La problématique est d'autant plus critique sur mobile, où la navigation doit être encore plus directe et intuitive. Un site dont la navigation mobile est mal adaptée perd mécaniquement du trafic, Google privilégiant désormais l'indexation mobile-first.

Manque de confiance

Les signaux de confiance jouent un rôle croissant dans les décisions de Google et dans le comportement des utilisateurs. Un site qui ne rassure pas les visiteurs sur son sérieux, son professionnalisme, ou sa sécurité voit son efficacité se dégrader progressivement.

Plusieurs éléments contribuent à cette perception de manque de confiance : absence de HTTPS (protocole sécurisé), design obsolète qui suggère un site non maintenu, mentions légales incomplètes ou absentes, absence de coordonnées de contact clairement visibles, fautes d'orthographe ou de syntaxe dans les contenus, publicités trop envahissantes, pop-ups agressifs.

Google intègre également des critères E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) dans l'évaluation de la qualité des sites, particulièrement pour les contenus relevant des secteurs YMYL (Your Money Your Life) : santé, finances, juridique. Un site qui ne démontre pas clairement l'expertise de ses auteurs, qui ne cite pas ses sources, ou qui ne fournit pas de garanties de fiabilité perd progressivement des positions face à des concurrents qui cochent ces cases.

Cette dimension devient particulièrement critique dans un contexte où les utilisateurs sont de plus en plus sensibles aux questions de protection des données personnelles, de véracité de l'information, et de sérieux des acteurs en ligne. Un site qui génère des signaux négatifs de confiance voit son taux de rebond augmenter et ses conversions diminuer, indépendamment de la qualité intrinsèque de son offre.

Comment inverser la tendance

Face à une perte de trafic installée, la tentation est forte de multiplier les actions tous azimuts dans l'espoir de redresser rapidement la situation. Cette approche se révèle généralement inefficace, coûteuse, et parfois contre-productive. La méthodologie éprouvée repose sur trois phases structurées : diagnostic exhaustif, priorisation des actions, et suivi rigoureux des résultats.

Audit + diagnostic structuré

Le point de départ de toute démarche de redressement consiste à établir un diagnostic complet et factuel de la situation. Ce diagnostic doit couvrir l'ensemble des dimensions susceptibles d'expliquer la perte de trafic : technique, contenu, autorité, expérience utilisateur, concurrence.

La méthodologie développée par l'Agence Easy intègre plusieurs dizaines de points de contrôle répartis en sept grandes familles : indexation et crawlabilité, performances techniques et Core Web Vitals, architecture et maillage interne, qualité et fraîcheur des contenus, optimisation on-page, profil de liens, signaux d'engagement utilisateur.

Cet audit SEO complet doit déboucher sur une cartographie précise des forces et faiblesses du site, avec pour chaque problématique identifiée une évaluation de son impact probable sur la perte de trafic et une estimation du délai de correction.

L'erreur fréquente consiste à se focaliser uniquement sur la dimension qui correspond aux compétences internes disponibles (souvent le contenu) en négligeant des problématiques techniques pourtant déterminantes. Un diagnostic rigoureux nécessite une approche pluridisciplinaire et des outils adaptés : Google Search Console, Google Analytics, outils de crawl technique, analyseurs de performances, outils de suivi de positionnements.

Plan d'optimisation priorisé

Une fois le diagnostic établi, la tentation est forte de vouloir tout corriger simultanément. Cette approche se heurte rapidement aux contraintes de ressources (temps, budget, compétences) et conduit souvent à des chantiers inachevés qui n'apportent aucun résultat tangible.

La priorisation doit s'appuyer sur deux critères : l'impact potentiel sur le trafic et la facilité de mise en œuvre. Les actions à fort impact et faible complexité doivent être traitées en priorité (quick wins). Les chantiers à fort impact mais forte complexité doivent être planifiés avec des ressources dédiées. Les actions à faible impact peuvent être différées ou abandonnées, quelle que soit leur facilité de mise en œuvre.

Cette priorisation doit également tenir compte des interdépendances entre actions. Il est inutile de relancer une campagne de production de contenus si des problèmes d'indexation empêchent ces contenus d'être pris en compte par Google. Il est contre-productif de travailler sur l'optimisation des contenus existants si la lenteur technique du site continue de pénaliser toutes les pages.

Le plan d'action résultant doit être réaliste, séquencé dans le temps, avec des jalons mesurables et des responsabilités clairement assignées. L'expérience montre qu'un redressement significatif nécessite généralement entre 3 et 6 mois d'actions soutenues, selon l'ampleur de la dégradation initiale et l'intensité concurrentielle du secteur.

Suivi mensuel

Le référencement naturel reste une discipline empirique où les résultats d'une action ne sont jamais garantis avec certitude. Un plan d'optimisation, aussi bien conçu soit-il, doit faire l'objet d'un suivi rigoureux pour vérifier que les actions mises en œuvre produisent les effets attendus et ajuster la trajectoire si nécessaire.

Ce suivi mensuel doit intégrer plusieurs catégories d'indicateurs : évolution du trafic organique global et par segment, évolution des positions sur les requêtes stratégiques, évolution du nombre de pages indexées, évolution des métriques d'engagement (taux de rebond, pages par session, durée), évolution des conversions générées par le canal organique.

L'analyse de ces indicateurs permet d'identifier rapidement les actions qui fonctionnent et celles qui ne produisent pas les résultats escomptés. Elle permet également de détecter de nouveaux problèmes qui pourraient apparaître : mise à jour algorithmique défavorable, nouveau concurrent agressif, problème technique non identifié lors de l'audit initial.

Cette démarche itérative d'optimisation continue constitue désormais la norme sur les secteurs concurrentiels. Les acteurs qui maintiennent leurs positions sont ceux qui ont intégré le SEO comme une fonction permanente de pilotage de leur visibilité, et non comme un projet ponctuel traité tous les deux ou trois ans lorsque le trafic a déjà significativement décru.

La perte progressive de trafic d'un site Internet résulte rarement d'une cause unique et isolée. Elle procède généralement de l'accumulation de micro-dégradations techniques, éditoriales et concurrentielles qui finissent par produire un effet cumulatif significatif. Comprendre que le contenu seul ne suffit plus en SEO constitue une première étape vers une approche plus globale et plus efficace.

L'enjeu consiste à identifier suffisamment tôt les signaux de dégradation pour intervenir avant que la situation ne devienne critique. Plus l'intervention est précoce, plus elle est simple et efficace. À l'inverse, laisser un site dériver pendant plusieurs années conduit à des situations où le redressement nécessite des investissements très significatifs, parfois supérieurs au coût d'une refonte complète.

Les cas où le site Internet n'apparaît plus sur Google représentent l'aboutissement de cette dégradation progressive. De même, constater qu'un site Internet ne génère pas de contacts résulte souvent d'une perte de trafic non détectée ou non traitée à temps.

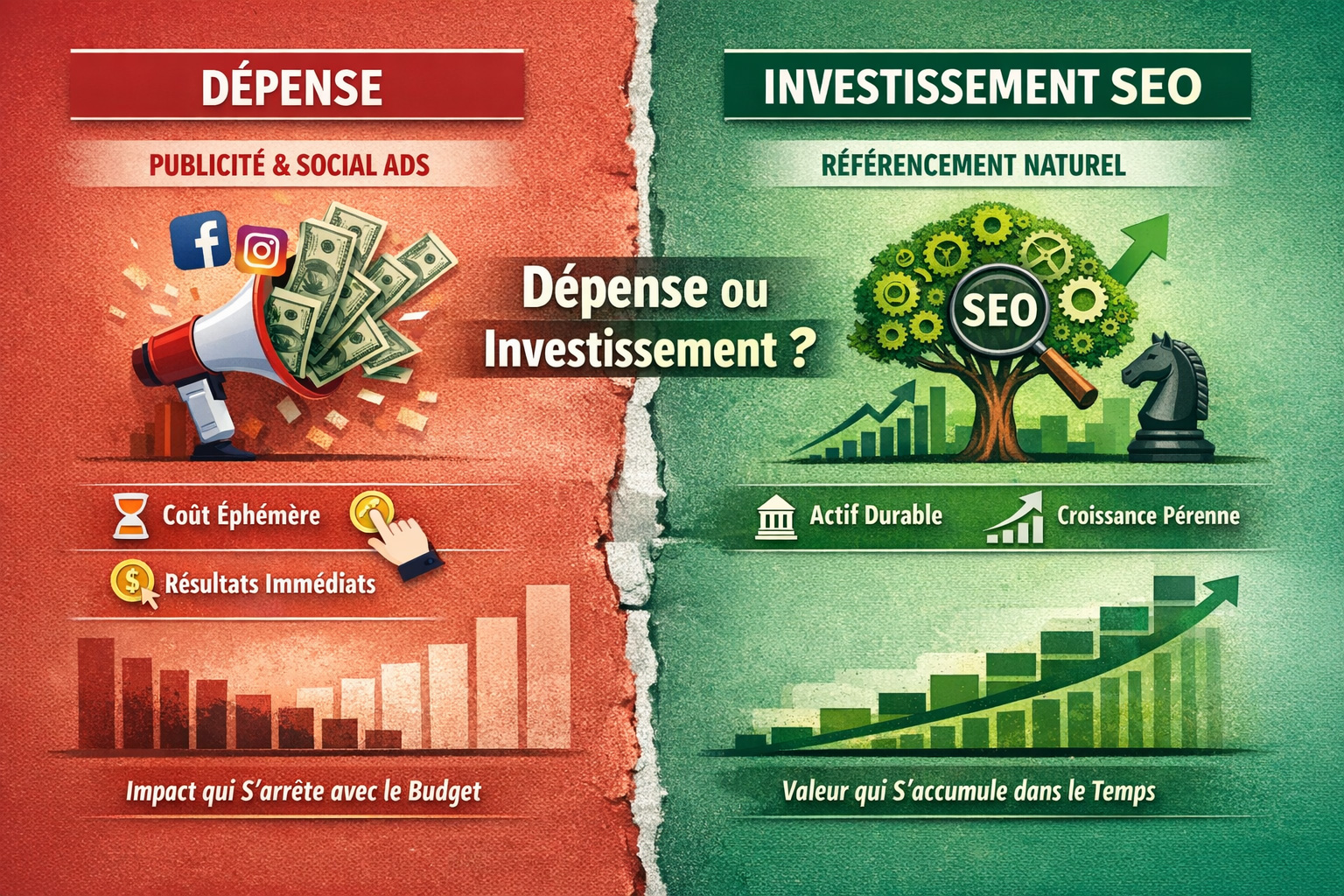

La visibilité organique constitue un actif stratégique pour toute entreprise présente en ligne. Comme tout actif, elle nécessite un entretien régulier, des investissements adaptés, et un pilotage attentif. Les organisations qui intègrent cette dimension dans leur gouvernance digitale sont celles qui maintiennent leur avantage concurrentiel dans la durée.